![]() 发布时间:2024-07-28

发布时间:2024-07-28![]() 作者:光明实验室

作者:光明实验室![]() 浏览:5767次

浏览:5767次

光明实验室媒体智能团队文章“CodeSwap: Symmetrically Face Swapping Based on Prior Codebook”(作者:罗向阳、张鑫、谢奕凡、童鑫熠、余伟江、常恒、马飞、于非)被人工智能领域CCF-A类会议ACM Multimedia 2024录用。光明实验室为第一作者单位和通讯作者单位。

01 内容简介

换脸技术(Face Swap),即将一个面部的身份转移到另一个面部的技术,在实际应用中具有重要意义。然而当前任务面临着一些重要问题:首先当前换脸算法通常会出现一些明显的可见伪影,这导致生成的结果通常不真实;此外,当面部存在遮挡时当前换脸算法通常表现较差,通常表现在换脸后面部遮挡消失。

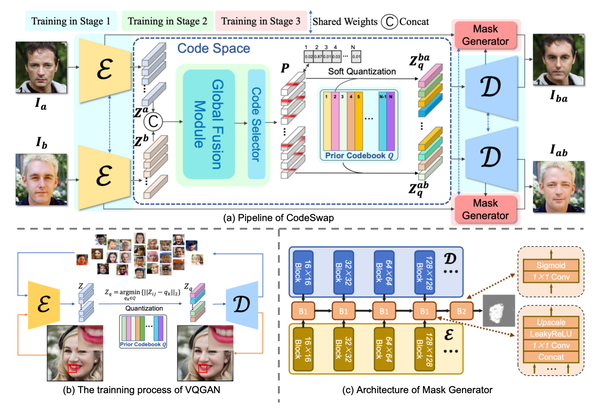

为了解决这些问题,本研究提出了一种基于高质量人脸先验的换脸算法CodeSwap,实现高保真和真实的面部替换。该方法首先利用VQGAN和离散编码本,通过大量高保真人脸重建任务来捕捉高质量的面部表示。在此基础上,面部替换被转化为在代码空间内进行的代码操作任务。为此,该方法设计了一种对称的Transformer架构,可同时捕获两张输入人脸的信息,独立更新面部表征,同时生成细粒度的双向换脸结果。此外,该方法还引入了一个掩码生成器,通过捕捉编码器和解码器中间层特征的差异来处理面部遮挡问题,并将生成的面部无缝地与目标图像背景融合。

02 方法概述

该工作训练过程可分3步:首先利用大量的高清人脸图像通过重建任务训练VQGAN,从而让codebook捕获高质量的人脸先验;接着冻结VQGAN和codebook,利用换脸任务的损失函数优化基于Transformer的对称融合模块,该模块的输入是拼接后的两个人脸表征,故能同时捕获两张人脸的全局信息,从而实现换脸。最后锁住前两阶段训练参数,通过无监督方式训练掩码生成模块,让其能自动区分身份相关区域和无关区域,从而实现背景保留和遮挡处理。通过三阶段训练,该方法实现了高保真的换脸,并且能较为有效地保留面部遮挡。

03 实验结果

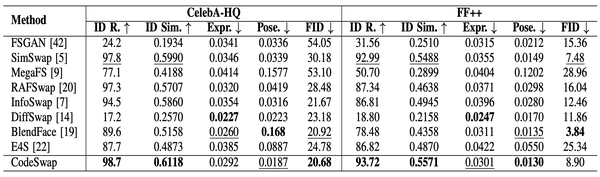

下方表格展示了所提方法CodeSwap在CelebA-HQ和FaceForensics++两个数据集的换脸定量结果。可见,CodeSwap在大多数指标中超越了现有方法,证明了其优越性。

原文

Xiangyang Luo, Xin Zhang, Yifan Xie, Xinyi Tong, Weijiang Yu, Heng Chang, Fei Ma #, Fei Richard Yu. CodeSwap: Symmetrically Face Swapping Based on Prior Codebook. Accepted by ACM Multimedia 2024.

※※※※※※※※※※※※※※※

此外,该团队负责人马飞研究员还有一篇合作论文“SegTalker: Segmentation-based Talking Face Generation with Mask-guided Local Editing”也被ACM Multimedia 2024接收。该工作通过学习语音信号与人脸分割图的映射关系以进行说话人脸生成。以上论文展现了媒体智能团队在以人为中心可视内容生成上的强大创新力。

媒体智能团队常年招收研究型实习生,从事数字人、图片与视频生成或编辑、人与物交互生成、人与场景交互生成、多模态大模型、情感智能等工作,发表高水平论文,并提供计算资源与有竞争力的实习薪资,欢迎感兴趣的本硕博同学进行联系(mafei@gml.ac.cn)。也欢迎感兴趣的企业、科研院所等单位交流、合作。

END

素 材 丨 光明实验室媒体智能团队

编 辑 丨 李沛昱